KI in Mitarbeiterbefragungen: Wie offene Kommentare sinnvoll analysiert werden

In der heutigen Arbeitswelt gewinnen Mitarbeiterbefragungen zunehmend an Bedeutung, um das Engagement und die Zufriedenheit der Belegschaft zu messen. Besonders in großen Unternehmen, in denen eine Vielzahl an offenen Kommentaren abgegeben wird, stellt die Auswertung dieser Daten eine Herausforderung dar. Während KI und speziell Large Language Models (LLMs) immer häufiger als Lösung für diese Herausforderung ins Spiel kommen, bleibt noch unklar, wie weit die Technologie tatsächlich geht und welche konkreten Möglichkeiten sie bietet. Im Gespräch mit Daniela, unserer Ansprechpartnerin für Kunden, gibt unser KI-Experte Philipp spannende Einblicke hinter die Kulissen und erklärt, wie LLMs und andere, für spezielle Anwendungsfälle optimierte Sprachmodelle eingesetzt werden können, um die Analyse von offenen Kommentaren in Mitarbeiterbefragungen zu optimieren. Wir werfen einen Blick auf die Chancen, aber auch auf die Herausforderungen, die mit dem Einsatz dieser Technologie verbunden sind.

Daniela: Hi Philipp, vielen Dank zunächst einmal für deine Zeit. Immer mehr Kunden wollen nicht mehr auf den Einsatz von KI bei Mitarbeitendenbefragungen verzichten. Was sind denn typische Anwendungsbereiche, die du für die functionHR Plattform entwickelt hast und noch weiter entwickeln wirst?

Philipp: Wir nutzen KI hauptsächlich, um offene Kommentare zu analysieren, Stimmungen zu erfassen und darauf aufbauend Handlungsempfehlungen abzuleiten. Dabei kommen LLMs (Large Language Modelle) zum Einsatz, um große Textmengen zusammenzufassen und häufig genannte Probleme oder Stärken schnell sichtbar zu machen. Für das genaue Identifizieren und Zuordnen von Kategorien – zum Beispiel „Teamkommunikation“ oder „Work-Life-Balance“ – verwenden wir hingegen spezialisierte Machine-Learning-Modelle. Zudem setzen wir weitere KI-Modelle für Aufgaben wie Übersetzungen ein. So können Unternehmen rasch auf kritische Themen reagieren und die gewonnenen Erkenntnisse direkt in konkrete Maßnahmen überführen.

Daniela: Kannst du mir als Laien in einfachen Worten erklären, was Large Language Modelle sind und wie man damit automatisch Kategorien oder Themen aus offenen Antworten ableiten kann?

Philipp: Large Language Modelle (LLMs) sind KI-Systeme, die auf enormen Textmengen trainiert werden, um Sprache zu verstehen und angemessen zu verarbeiten. Sie zerlegen Texte in viele Bestandteile und lernen, wie Wörter und Sätze in unterschiedlichen Kontexten zusammenhängen. Dadurch entwickelt sich eine Art „sprachliches Weltwissen“, das für diverse Aufgaben genutzt werden kann – zum Beispiel beim Erfassen grundlegender Stimmungen in Freitexten.

Für das Zuweisen einer konkreten Antwort zu einer bestimmten Kategorie – wie „Führung“ oder „Teamarbeit“ – verwenden wir ein speziell für diese Aufgabe optimiertes Machine-Learning-Verfahren. Dieses Modell wird gezielt darauf trainiert, typische Schlüsselwörter und Formulierungen für bestimmte Themen zu erkennen und die Antworten entsprechend einzuordnen.

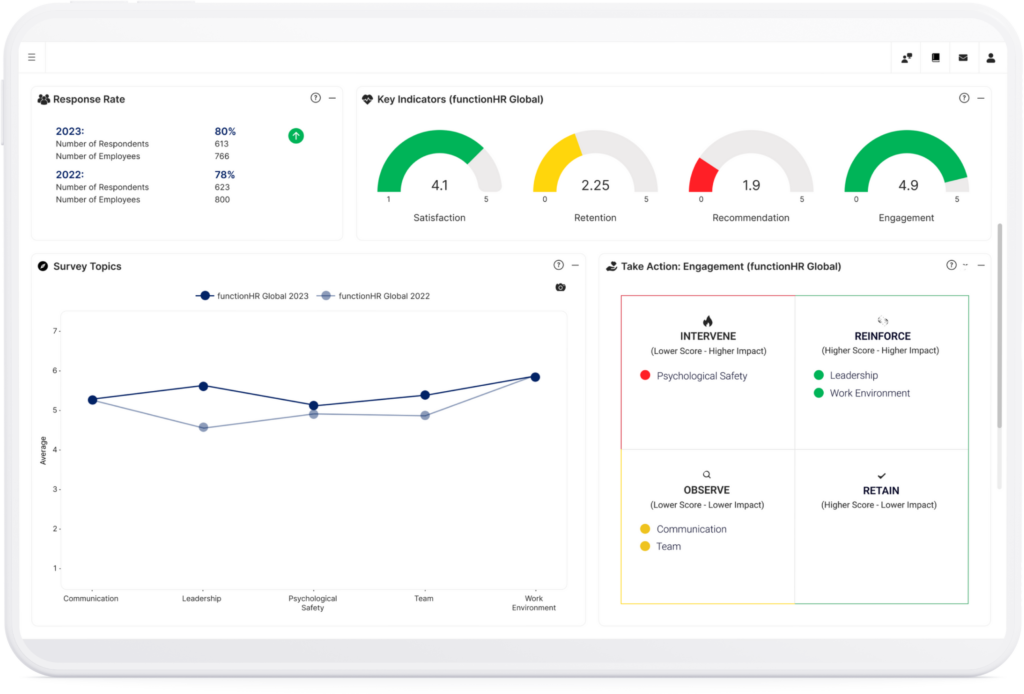

Mitarbeiterbefragungen mit unserer All-in-One-Lösung

Wir vereinen Befragungen, Analysen und KI-gestützte Folgeprozesse in einer Software.

Daniela: Welche Vorteile bieten LLMs gegenüber traditionellen Analysemethoden für offene Kommentare in Mitarbeiterbefragungen?

Philipp: Der größte Vorteil von LLMs ist, dass sie bereits ein enormes Weltwissen mitbringen und keine riesigen, extra annotierten Trainingsdatensätze benötigen. LLMs hingegen verstehen im Grundzustand oft bereits viele Sprachen, Fachbegriffe und Formulierungen und können deshalb auch unstrukturierte Texte schnell auf Kernaussagen reduzieren. Zudem lassen sich mit LLMs große Mengen an Kommentaren effizient verarbeiten, um schnell einen Grobüberblick zu bekommen.

Daniela: Wie gut sind aktuelle LLMs mittlerweile darin, Stimmungen, Themen und Trends aus offenen Kommentaren zu extrahieren?

Philipp: Sehr gut! Die modernen Modelle sind mittlerweile sehr leistungsfähig! Sie können nicht nur Stimmungen erkennen, sondern auch tiefere Zusammenhänge zwischen verschiedenen Themen herstellen und Trends über unterschiedliche Befragungen hinweg identifizieren. Dabei sind gut gestaltete Prompts und eine kontinuierliche Qualitätssicherung entscheidend für präzise Ergebnisse. Bei functioHR habe ich mich intensiv damit beschäftigt, wie man Prompts optimieren kann, um hochwertige Analysen zu erzielen. Besonders wichtig ist es, der KI den Kontext klar zu vermitteln – zum Beispiel, wenn es um spezifische Themen wie Führungskräfteentwicklung geht – und klare Anweisungen zu geben. Ein effektiver Prompt sollte die KI auffordern, nahe am Text zu bleiben und eine möglichst objektive Interpretation zu liefern. Wie gut Prompts funktionieren, hängt jedoch auch stark von dem verwendeten LLM und seiner Feinabstimmung ab.

Daniela: Das ist spannend. Wie viele verschiedene LLM Modelle gibt es denn und welche funktionieren gut?

Philipp: Es gibt unzählige LLM-Varianten basierend auf der technischen Architektur oder auch des Anwendungsfalls. In unserem Fall werden sogenannte Open Source Modelle, also kommerziell nutzbare, vortrainierte Modellartefakte verwendet, die in unserer eigenen Infrastruktur betrieben werden. Für unsere Zwecke unterscheiden wir grob zwischen:

- Spezialisierte (prädiktive) Modelle: Diese sind explizit auf bestimmte Aufgaben, wie beispielsweise Übersetzung oder Datensätze zugeschnitten. So nutzen wir etwa Modelle, die sehr präzise Themen in Mitarbeiterkommentaren erkennen, weil sie eigens dafür trainiert wurden.

- Generative Modelle: Diese sind sehr gut darin, Texte zu verstehen, zusammenzufassen oder neu zu formulieren. Sie bringen oft ein enormes Sprachwissen mit und können große Datenmengen verarbeiten.

In der Praxis mischen wir Ansätze. Beispielsweise nutzen wir ein spezialisiertes Modell für Topic Detection und ein generatives LLM, um größere Textblöcke sinnvoll zusammenzufassen oder Handlungsempfehlungen zu entwerfen. Der optimale Ansatz hängt dabei von Faktoren wie Schnelligkeit, Präzision, Verfügbarkeit und natürlich der gewünschten Detailtiefe ab.

functionHR Webseminare

Mitarbeiterbefragungen erfolgreich und nachhaltig

umsetzen

functionHR Webseminare

Mitarbeiterbefragungen erfolgreich und nachhaltig

umsetzen

Daniela: Welche Herausforderungen gibt es bei der Analyse von Freitextantworten in großem Umfang?

Philipp: Die Analyse von Freitextantworten in großem Umfang ist herausfordernd, weil sie inhaltlich und strukturell stark variieren – sei es in der Länge, der Detailtiefe oder der verwendeten Sprache. Dadurch wird die Kategorisierung erschwert, besonders wenn plötzlich völlig neue Themen (sogenannte „Blind Spots“) auftreten. Hinzu kommt, dass LLMs nur eine begrenzte Textmenge am Stück verarbeiten können – längere Texte müssen also segmentiert werden, was zu Informationsverlust führen kann. Auch Mehrsprachigkeit, Dialekte und Fachjargon erhöhen die Komplexität. Um diesen Herausforderungen zu begegnen, setzen wir auf eine Kombination aus verschiedenen (sprach-)spezifischen Modellen, die automatisch neue Themen identifizieren und effizient einordnen.

Daniela: Das Thema Datenschutz ist ein wichtiges Stichwort. Welche Datenschutzaspekte müssen Unternehmen beachten, wenn sie KI zur Analyse offener Kommentare einsetzen?

Philipp: Alle Daten sollten anonymisiert und gemäß den geltenden Datenschutzrichtlinien, wie beispielsweise der DSGVO, verarbeitet werden. Besonders kritisch ist der unsachgemäße Umgang mit offenen Kommentaren in frei zugänglichen KI-Tools, da dies den üblichen Datenschutzauflagen bei Mitarbeiterbefragungen widersprechen kann. Stattdessen sollten Unternehmen auf sichere, datenschutzkonforme Lösungen setzen.

Bei functionHR hosten wir beispielsweise unsere LLMs selbst. So wird sichergestellt, dass Kundendaten nicht zu Trainingszwecken „missbraucht“ werden und alle IT und Datenschutzanforderungen eingehalten werden. Ebenso kann bei Mitarbeitenden Vertrauen in die KI-Lösungen gestärkt werden, indem transparent kommuniziert wird, dass die KI keine individuellen Aussagen bewertet, sondern nur aggregierte Trends analysiert. Insbesondere auch strikte Datenlöschungsrichtlinien sind für einen vertrauensvollen Umgang wichtig: Wir löschen personenbezogene Daten vor der Analyse und speichern nur notwendige Informationen.

Daniela: Wie kann man sicherstellen, dass die KI objektiv bleibt und keine Verzerrungen (Bias) in der Analyse entstehen?

Philipp: Da KI-Modelle immer auf vorhandenen Daten beruhen, lassen sich Verzerrungen (Bias) nie vollständig ausschließen. Durch sorgfältige Auswahl der Trainingsdaten, regelmäßige Validierung der Ergebnisse und Kombination mit menschlichem Feedback kann dies jedoch deutlich reduziert werden.

Daniela: Kannst du uns noch einen Zukunftsausblick geben? Wie wird sich die Nutzung von LLMs in der Mitarbeitendenbefragung in den nächsten Jahren entwickeln?

Philipp: In Zukunft werden wir noch intuitiver mit den Modellen interagieren können – etwa in einer Art „Dialog“, bei dem die KI nicht nur Ergebnisse liefert, sondern auch erklärt, wie sie zustande gekommen sind. Gleichzeitig werden die Modelle immer effizienter und kleiner, sodass sie bei gesteigerter Geschwindigkeit und Qualität auch große Datenmengen bewältigen können, ohne Unmengen an Rechenkapazität zu beanspruchen.

Wichtig ist jedoch, dass wir mehr „Guardrails“ implementieren, um Halluzinationen zu minimieren und sicherzustellen, dass die KI nur für ihre vorgesehenen Aufgaben eingesetzt wird. KI hat zwar enormes Potenzial, doch sie sollte stets verantwortungsvoll und mit kontinuierlicher Qualitätsprüfung genutzt werden – insbesondere, wenn es um wichtige Entscheidungen im Mitarbeiterfeedback geht.

Entdecken Sie, wie Sie Ihre Führungskräfte mit Feedback aus deren Verantwortungsbereichen fördern können.

Weitere Artikel

Warum ist People Analytics so wichtig für HR?

Ohne Navigation in einer neuen Umgebung – gute Idee? Stellen Sie sich vor, Sie befinden sich in einer fremden Stadt. Sie kennen Ihren Standort und

Wie unseriöses Fragebogendesign zu Antwortverzerrungen führen kann

In der heutigen Arbeitswelt wird es immer wichtiger für Unternehmen, neben „harten“ Daten wie z.B. dem Alter oder den Fehltagen der Mitarbeiter:innen auch sogenannte „weiche“

HAI und functionHR holen den Trendence Award 2020 für data-driven HR

Am gestrigen Abend wurden im Rahmen einer Online-Gala die besten HR Projekte des Jahres 2020 mit den Trendence Awards ausgezeichnet. Herzlichen Glückwunsch zum Sieg! Unser